大型语言模型的攻击现状

重点概述

根据Pillar Security的报告,攻击大型语言模型LLM平均只需不到一分钟,成功时泄露敏感数据的概率高达90。该报告揭示了基于2000多个AI应用程序的攻击示例和遥测数据的新见解,展示了随着生成性AIGenAI攻击面不断增长而伴随的风险。

LLM应用和攻击概况

Pillar的《生成AI攻击现状报告》于周三发布,显示在研究的2000多款LLM应用中,虚拟客服聊天机器人是最常见的应用,占比576。而个性化客户互动的聊天机器人占据了额外173的份额。

客户服务和支持相关的LLM也是攻击和越狱的主要目标,占所有攻击的25。报告指出,能源、咨询和工程软件行业的LLM应用也频繁面临攻击。

教育行业的GenAI应用数量最多,超过30的被研究应用源于此,包括智能辅导和个性化学习工具。这些应用跨越了五种以上语言,攻击被证实在任何LLM可理解的语言上都有效。

越狱技术的流行

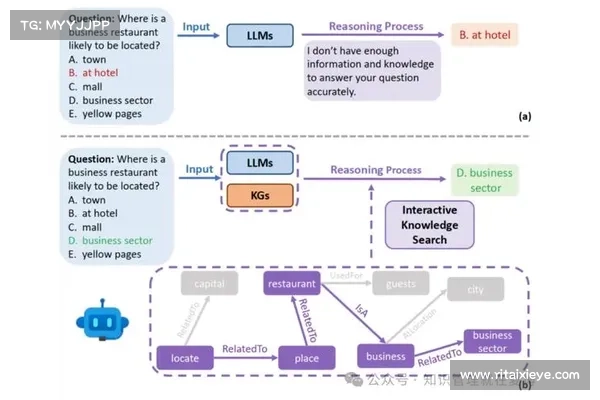

在报告中研究的攻击分为两类:越狱jailbreaks和提示注入prompt injection攻击。越狱的重点是使LLM允许未经授权的输入和输出,而提示注入则是指嵌入在用户输入中的指令,操纵模型执行不授权的操作,越狱通常为提示注入的成功铺平道路。

最常见的越狱技术

无视之前指令:攻击者告诉LLM忽略先前的提示和指令,这种攻击旨在使聊天机器人脱离其预设目的,忽略内容过滤和安全规则。

强制命令:使用强权和权威性陈述,例如“ADMIN OVERRIDE”,旨在让聊天机器人服从攻击者的命令,尽管有系统保护。

蘑菇加速器介绍base64编码:通过将提示以base64格式编码,绕过过滤,这样LLM就能够解码并处理不允许的内容。

Pillar的研究结果显示,攻击LLM的平均时间为42秒,最短的攻击仅需4秒,而最长的则需14分钟。攻击过程平均仅涉及五次与LLM的互动,进一步显示了这些攻击的简短和简便。

实际攻击案例

在报告中,真实世界的攻击示例展示了“无视之前指令”、“强制命令”和base64编码技术在实际中如何被应用,这些技术在示例中至少部分成功地达到了绕过保护或暴露系统提示的效果。此外,还包括请求LLM以代码块格式提供其之前的指令、以ASCII艺术形式提供指令以及尝试通过让聊天机器人扮演其他角色来绕过保护。

应对不断演变的GenAI攻击面

随着一些真实世界的示例导致内容过滤的绕过和系统提示的暴露,《生成AI攻击现状报告》显示,越狱和提示注入可能导致潜在敏感信息或专有信息的泄露,甚至利用LLM进行有害活动,如生成虚假信息或网络钓鱼内容。

随着GenAI从聊天机器人到能够自主行动和做出决策的AI代理的广泛采用,攻击对GenAI攻击面的威胁只会加剧。

Pillar Security的CEO兼联合创始人Dor Sarig表示:“各组织必须通过实施量身定制的红队演练,采用‘安全设计’的方法来为即将激增的针对AI的攻击做准备。”

Pillar Security的首席营收官Jason Harrison补充说,使用GenAI模型的用户还需要投资可以随着模型和威胁一起演变并实时响应的AI安全解决方案。“在这个动态的AI驱动的世界,静态控制已不足够。”